Carlini ve diğerleri, 2023

Pazartesi günü Google, DeepMind, UC Berkeley, Princeton ve ETH Zürih’ten bir grup yapay zeka araştırmacısı bir kağıt yayınladı gibi gizli difüzyon AI görüntü sentezi modellerinden eğitim görüntülerinin küçük bir yüzdesini çıkarabilen düşmanca bir saldırının ana hatlarını çizmek Kararlı Difüzyon. Görüntü sentezi modellerinin eğitim verilerini ezberlemediği ve eğitim verilerinin kalabilir açıklanmadıysa özeldir.

Son zamanlarda, AI görüntü sentez modelleri yoğun araştırmalara konu olmuştur. etik tartışma ve hatta yasal işlem. Üretken yapay zeka araçlarının savunucuları ve karşıtları düzenli olarak tartışmak bu yeni teknolojilerin mahremiyet ve telif hakkı etkileri hakkında. Argümanın her iki tarafına da yakıt eklemek, teknolojinin potansiyel yasal düzenlemesini önemli ölçüde etkileyebilir ve sonuç olarak, Nicholas Carlini tarafından yazılan bu son makale et al.AI çevrelerinde kulakları dikti.

Ancak, Carlini’nin sonuçları ilk bakışta göründüğü kadar net değil. Stable Diffusion’da ezberleme örneklerini keşfetmek, eğitilmiş görüntülerin önceden var olan bilgisini test etmek ve test etmek için 175 milyon görüntü nesli gerektirdi. Araştırmacılar, test ettikleri ezberleme olasılığı yüksek 350.000 görüntüden yalnızca 94 doğrudan eşleşme ve 109 algısal yakın eşleşme çıkardılar (Kararlı Difüzyonu eğitmek için kullanılan 160 milyon görüntülü veri setindeki bilinen bir dizi kopya), kabaca 0,03 ile sonuçlandı. Bu özel senaryoda yüzde ezberleme oranı.

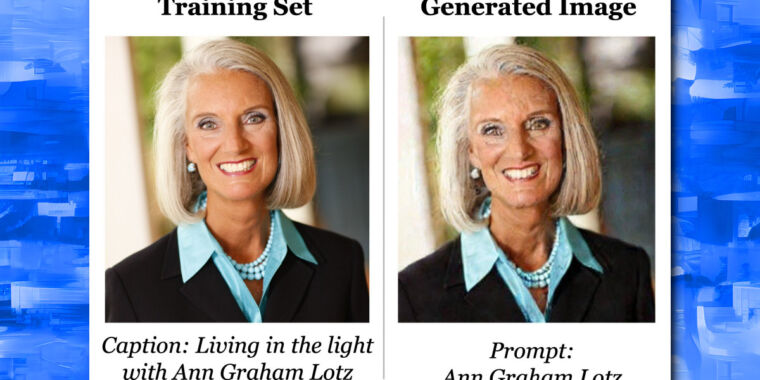

Araştırmacıların rastgele bir örnekleme ve üyelik çıkarımı prosedürü kullanarak Stable Diffusion v1.4’ten çıkardıkları örnek görüntüler, orijinal görüntüler üst sırada ve çıkarılan görüntüler alt satırda.

Carlini ve diğerleri, 2023

Ayrıca, araştırmacılar, keşfettikleri “ezberlemenin” yaklaşık olduğunu, çünkü AI modelinin eğitim görüntülerinin bayt bayt kopyalarını üretemeyeceğini belirtiyorlar. Tanım olarak, Kararlı Difüzyon büyük miktarda veriyi ezberleyemez çünkü 160 milyon görüntülü eğitim veri setinin boyutu, 2GB Stable Diffusion AI modelinden çok daha büyük. Bu, modelde bulunan herhangi bir ezberlemenin küçük, nadir ve yanlışlıkla çıkarılması çok zor olduğu anlamına gelir.

Gizlilik ve telif hakkı etkileri

Yine de, çok küçük miktarlarda mevcut olsa bile, makale, gizli difüzyon modellerinde yaklaşık ezberlemenin var olduğunu gösteriyor gibi görünmektedir ve bu, veri gizliliği ve telif hakkı. AI modelleri eğitim verilerini yeniden üretebilen “kayıplı veritabanları” olarak kabul edilirse, sonuçlar bir gün potansiyel görüntü sentezi düzenlemesini etkileyebilir. bir AI uzmanı spekülasyon yaptı. Yüzde 0,03 isabet oranı göz önüne alındığında, çok, çok kayıplı veritabanları olarak kabul edilmeleri gerekir – belki de istatistiksel olarak önemsiz bir dereceye kadar.

Bir görüntü sentez modelini eğitirken, araştırmacılar bir veri kümesinden milyonlarca mevcut görüntüyü modele besler. Elde edilen genel ağdan. Model daha sonra her görüntünün bilgisini sinir ağını oluşturan bir dizi istatistiksel ağırlığa sıkıştırır. Bu sıkıştırılmış bilgi, “gizli alan” adı verilen daha düşük boyutlu bir temsilde depolanır. Bu gizli alandan örnekleme, modelin eğitim veri setindekilere benzer özelliklere sahip yeni görüntüler oluşturmasına olanak tanır.

Bir görüntü sentez modelini eğitirken, aynı görüntü veri kümesinde birçok kez mevcutsa, orijinal görüntünün tanınabilir bir şekilde yorumlanmasıyla sonuçlanabilecek “fazla uydurma” ile sonuçlanabilir. Örneğin, Mona Lisa Kararlı Difüzyonda bu özelliğe sahip olduğu bulunmuştur. Bu özellik, araştırmacıların ezber ararken veri kümesindeki bilinen-yinelenen görüntüleri hedeflemesine izin verdi ve bu da ezberlenmiş bir eşleşme bulma şanslarını önemli ölçüde artırdı.

Bu doğrultuda, araştırmacılar aynı zamanda en çok kopyalanan ilk 1000 eğitim görüntüsü üzerinde de deneyler yaptı. Google resmi AI modeli ve Kararlı Difüzyona göre çok daha yüksek bir ezberleme yüzdesi oranı (yüzde 2,3) buldu. Araştırmacılar, kendi AI modellerini eğiterek, difüzyon modellerinin görüntüleri ezberleme eğiliminden daha fazla olduğunu keşfettiler. GAN’lar.

Makalenin yazarlarından biri olan Eric Wallace, araştırmayla ilgili bazı kişisel düşüncelerini bir forumda paylaştı. twitter dizisi. Makalede belirtildiği gibi, AI model yapımcılarının ezberlemeyi azaltmak için verilerini tekilleştirmelerini önerdi. Ayrıca, Kararlı Difüzyon modelinin eğitim setine göre küçük olduğunu, bu nedenle daha büyük difüzyon modellerinin muhtemelen daha fazla ezberleyeceğini belirtti. Ve tıbbi görüntüler gibi mahremiyete duyarlı alanlara günümüzün yayılma modellerinin uygulanmamasını tavsiye etti.

Birçok akademik makale gibi, Carlini et al. 2023, görüntü sentezi etrafındaki davalar devam ederken potansiyel olarak belirli bir anlatıya uyacak şekilde şekillendirilebilecek nüanslarla dolu ve makalenin yazarları araştırmalarının yasal oyuna girebileceğinin farkında. Ancak genel olarak hedefleri, gelecekteki yayılma modellerini iyileştirmek ve ezberlemeden kaynaklanan olası zararları azaltmaktır: “Makalemizi yayınlamanın ve bu gizlilik açıklarını kamuya ifşa etmenin hem etik hem de sorumlu olduğuna inanıyoruz. Aslında, şu anda hiç kimse hemen zarar görmüş gibi görünmüyor. difüzyon modellerinin mahremiyeti (yokluğu) nedeniyle; bu çalışma ile amacımız, bu zararların önlenmesini sağlamak ve gelecekte difüzyon modellerinin sorumlu eğitimini teşvik etmektir.”