Google Araştırması

Pazartesi günü, Google’dan ve Berlin Teknik Üniversitesi’nden bir grup AI araştırmacısı, PALM-E562 milyar ile çok modlu bir somutlaştırılmış görsel dil modeli (VLM) parametreler robotik kontrol için görüş ve dili bütünleştiren. Şimdiye kadar geliştirilmiş en büyük VLM olduğunu ve yeniden eğitime ihtiyaç duymadan çeşitli görevleri yerine getirebileceğini iddia ediyorlar.

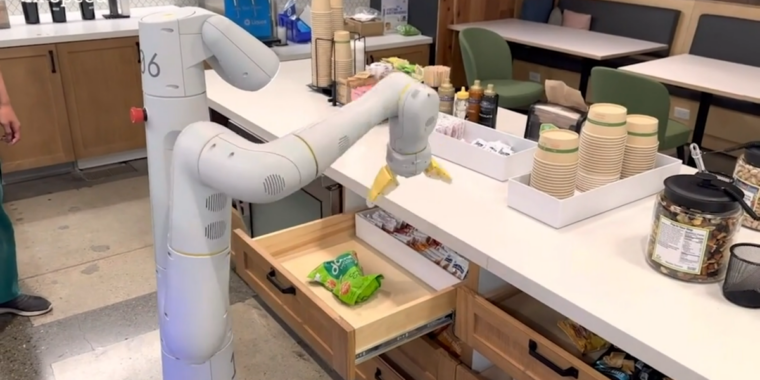

Google’a göre, “çekmeceden pirinç cipslerini bana getir” gibi üst düzey bir komut verildiğinde, PaLM-E kollu bir mobil robot platformu için bir eylem planı oluşturabilir (Google Robotics tarafından geliştirilmiştir) ve uygulayabilir. eylemlerin kendisi.

PaLM-E bunu, önceden işlenmiş bir sahne temsiline ihtiyaç duymadan robotun kamerasından gelen verileri analiz ederek yapar. Bu, bir insanın verileri önceden işlemesi veya açıklama eklemesi ihtiyacını ortadan kaldırır ve daha otonom robotik kontrole izin verir.

Google tarafından sağlanan bir demo videoda PaLM-E, robotun kamerasından gelen görsel geri bildirimin yanı sıra birden fazla planlama adımı içeren “çekmeceden pirinç cipslerini bana getir” işlemini yürütür.

Aynı zamanda dayanıklıdır ve çevresine tepki verebilir. Örneğin, PaLM-E modeli şunları yapabilir: bir robota rehberlik etmek mutfaktan bir cips poşeti almak için – ve kontrol döngüsüne entegre edilmiş PaLM-E ile görev sırasında meydana gelebilecek kesintilere karşı dayanıklı hale gelir. Bir video örneğinde, bir araştırmacı çipleri robottan alır ve hareket ettirir, ancak robot çipleri bulur ve tekrar alır.

İçinde başka bir örnek, aynı PaLM-E modeli, daha önce insan rehberliği gerektiren karmaşık dizilere sahip görevler aracılığıyla bir robotu otonom olarak kontrol eder. Google’ın Araştırma kağıdı PaLM-E’nin talimatları nasıl eyleme dönüştürdüğünü açıklıyor:

PaLM-E’nin zorlu ve çeşitli mobil manipülasyon görevlerindeki performansını gösteriyoruz. Ahn ve diğerlerindeki kurulumu büyük ölçüde takip ediyoruz. (2022), burada robotun bir insan tarafından verilen talimata dayalı olarak bir dizi navigasyon ve manipülasyon eylemi planlaması gerekiyor. Örneğin, “İçeceğimi döktüm, temizlemek için bana bir şeyler getirir misin?” talimatı verildiğinde, robotun “1. Sünger bul, 2. Süngeri al, 3. Getir” şeklinde bir sıralama yapması gerekiyor. kullanıcıya, 4. Süngeri yere koyun.” Bu görevlerden ilham alarak, PaLM-E’nin somutlaştırılmış muhakeme yeteneklerini test etmek için 3 kullanım durumu geliştiriyoruz: satın alma tahmini, başarısızlık tespiti ve uzun ufuklu planlama. Düşük seviyeli politikalar, RGB görüntüsünü ve doğal dil talimatını alan ve son efektör kontrol komutlarını çıkaran bir transformatör modeli olan RT-1’den (Brohan ve diğerleri, 2022) alınmıştır.

PaLM-E bir sonraki belirteç tahmincisidir ve Google’ın “adlı mevcut geniş dil modelini (LLM) temel aldığı için “PaLM-E” olarak adlandırılır.Avuç içi” (arkasındaki teknolojiye benzer) ChatGPT). Google, duyusal bilgi ve robotik kontrol ekleyerek PaLM’yi “somutlaştırdı”.

Bir dil modeline dayandığından PaLM-E, görüntüler veya sensör verileri gibi sürekli gözlemler alır ve bunları dil belirteçleriyle aynı boyutta olan bir dizi vektöre kodlar. Bu, modelin duyusal bilgileri, dili işlediği şekilde “anlamasına” olanak tanır.

“Bana yeşil bir yıldız getirin” talimatını izleyen, PaLM-E tarafından yönlendirilen bir robotu gösteren, Google tarafından sağlanan bir demo video. Araştırmacılar, yeşil yıldızın “bu robotun doğrudan maruz kalmadığı bir nesne olduğunu” söylüyor.

Buna ek olarak RT-1 robotik transformatörPaLM-E, Google’ın önceki çalışmasından yararlanır. Vit-22B, Şubat ayında ortaya çıkan bir vizyon trafo modeli. ViT-22B, görüntü sınıflandırma, nesne algılama, semantik bölümleme ve görüntü alt yazısı gibi çeşitli görsel görevler konusunda eğitilmiştir.

Google Robotics, sinir ağlarıyla robotik kontrol üzerinde çalışan tek araştırma grubu değil. Bu özel çalışma, Microsoft’un son “Robotik için ChatGPTGörsel verileri ve büyük dil modellerini robotik kontrol için benzer şekilde birleştirmeyi deneyen kağıt.

Robotik bir yana, Google araştırmacıları, PaLM-E’nin çekirdeği olarak büyük bir dil modeli kullanmaktan kaynaklanan birkaç ilginç etki gözlemlediler. Birincisi, öğrendiği bilgi ve becerileri bir görevden diğerine aktarabilmesi anlamına gelen “pozitif aktarım” sergiliyor ve bu da tek görevli robot modellerine kıyasla “önemli ölçüde daha yüksek performans” sağlıyor.

ayrıca onlar gözlenen model ölçeğinde bir trend: “Dil modeli ne kadar büyük olursa, görsel dil ve robotik görevler üzerine eğitim verirken dil becerilerini o kadar fazla korur; niceliksel olarak, 562B PaLM-E modeli neredeyse tüm dil yeteneklerini korur.”

PaLM-E, bugüne kadar bildirilen en büyük VLM’dir. Yalnızca tek görüntülü istemler üzerinde eğitilmemize rağmen, çok modlu düşünce zinciri akıl yürütme ve çok görüntülü çıkarım gibi ortaya çıkan yetenekleri gözlemliyoruz. Çalışmamızın odak noktası olmasa da PaLM-E, OK-VQA kıyaslamasında yeni bir SOTA belirliyor. pic.twitter.com/9FHug25tOF

— Danny Driess (@DannyDriess) 7 Mart 2023

Ve araştırmacılar iddia PaLM-E’nin çok modlu düşünce zinciri muhakemesi (modelin hem dil hem de görsel bilgileri içeren bir dizi girdiyi analiz etmesine izin verir) ve çoklu görüntü çıkarımı (bir çıkarım veya tahmin yapmak için girdi olarak birden çok görüntüyü kullanma) gibi ortaya çıkan yetenekler sergilediği ) yalnızca tek görüntülü istemler konusunda eğitilmiş olmasına rağmen. Bu anlamda PaLM-E, trendi sürdürmek Derin öğrenme modelleri zamanla daha karmaşık hale geldikçe ortaya çıkan sürprizlerin sayısı.

Google araştırmacıları, ev otomasyonu veya endüstriyel robotik gibi gerçek dünya senaryoları için daha fazla PaLM-E uygulaması keşfetmeyi planlıyor. Ve PaLM-E’nin çok modlu akıl yürütme ve somutlaştırılmış yapay zeka hakkında daha fazla araştırmaya ilham vermesini umuyorlar.

“Multimodal”, şirketler olarak giderek daha fazla duyacağımız bir terimdir. yapay genel zekaya ulaşmak görünüşte bir insan gibi genel görevleri yerine getirebilecek.