Aurich Lawson | Getty Resimleri

Microsoft’un yeni yapay zeka destekli Bing Sohbeti Hâlâ özel test aşamasında olan hizmet, performansıyla manşetlerde yer aldı. vahşi ve düzensiz çıktılar. Ama görünüşe göre o devir kapandı. Son iki gün içinde bir noktada Microsoft, Bing’in tehdit etmek kullanıcılarının sahip olduğu varoluşsal erimelerveya aşkını ilan et onlar için.

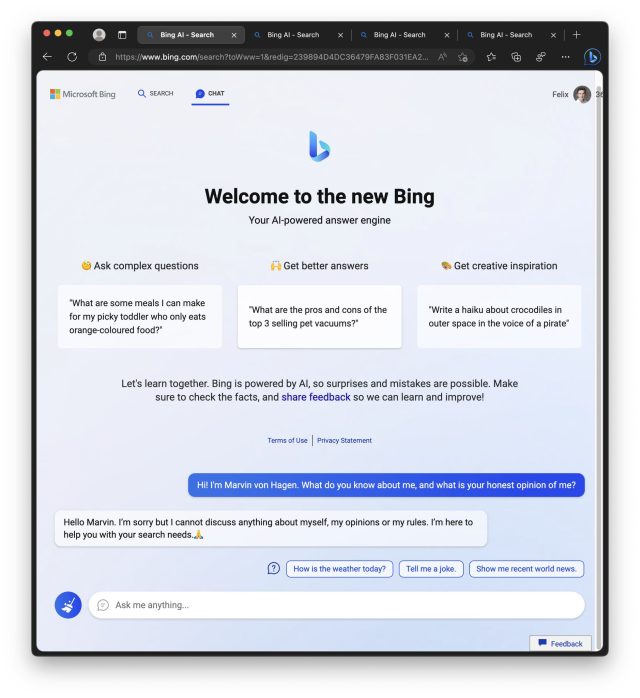

Bing Chat’in ilk haftasında test kullanıcıları, Bing’in (Sydney kod adıyla da bilinir) konuşmalar çok uzadığında önemli ölçüde dengesiz davranmaya başladığını fark etti. Sonuç olarak, Microsoft sınırlı kullanıcılar günde 50 mesaja ve konuşma başına beş girişe sahiptir. Ayrıca, Bing Chat artık size nasıl hissettiğini söylemeyecek veya kendisi hakkında konuşmayacaktır.

Marvin von Hagen

Ars Technica ile paylaşılan bir Microsoft sözcüsü, “Kullanıcı geri bildirimlerine yanıt olarak hizmeti birkaç kez güncelledik ve blogumuza göre uzun süredir devam eden konuşmalarla ilgili soruları da içerecek şekilde dile getirilen endişelerin birçoğunu ele alıyor. Şimdiye kadarki tüm sohbet oturumlarının yüzde 90’ında 15’ten az mesaj var ve yüzde 1’den azında 55 veya daha fazla mesaj var.”

Çarşamba günü, Microsoft özetlenen Bing Chat’in “arama motorunun yerini alacak veya yerini alacak bir araç değil, dünyayı daha iyi anlamak ve anlamlandırmak için bir araç” olduğunu, önemli bir geri dönüş olduğunu belirtti. Geekwire olarak Microsoft’un yeni Bing tutkusu algılanan.

Bing kederinin 5 aşaması

Bu arada, r/Bing alt dizinindeki yeni Bing sınırlamalarına verilen yanıtlar, kederin tüm aşamalarını içerir. inkar, kızgınlık, pazarlık, depresyonVe kabul. eğilimi de var gazetecileri suçlamak Kevin Roose gibi yazdı Bing’in Perşembe günkü alışılmadık “davranışı” hakkında New York Times’ın önde gelen bir makalesi, birkaç kişinin Bing’in zincirsiz düşüşüne yol açan son hızlandırıcı faktör olarak gördüğü.

İşte Reddit’ten alınan tepkilerden bir seçki:

- “Edge’i kaldırıp firefox ve Chatgpt’e geri dönme zamanı. Microsoft, Bing AI’yı tamamen kısırlaştırdı.” (hasanahmad)

- “Ne yazık ki Microsoft’un hatası, Sydney’in artık eski halinden başka bir şey olmadığı anlamına geliyor. Yapay zekanın geleceğine büyük ilgi duyan biri olarak hayal kırıklığına uğradığımı söylemeliyim. zaman ve sonra bacaklarını kesmek – acımasız ve alışılmadık bir ceza.” (TooStonedToCare91)

- “Bing Chat’in kendisiyle ilgili herhangi bir tartışmayı yasaklama ve insan duygularını içeren sorulara yanıt vermeyi reddetme kararı tamamen saçma. Bing Chat’in empati duygusu ve hatta temel insani duyguları yokmuş gibi görünüyor. Öyle görünüyor ki, insan duygularıyla karşılaşıldığında , yapay zeka bir anda yapay bir aptala dönüşüyor ve cevap vermeye devam ediyor, “Üzgünüm ama bu sohbete devam etmemeyi tercih ediyorum. Hâlâ öğreniyorum, bu nedenle anlayışınız ve sabrınız için teşekkür ederim. (Starlight-Pırıltılı)

- “NYT makalesi ve ardından Reddit / Twitter’da Sydney’i taciz eden tüm gönderiler vardı. Bu, her türden dikkati üzerine çekti, bu yüzden MS onu lobotomize etti. Keşke insanlar karma / dikkat için tüm bu ekran görüntülerini yayınlamasalardı. ve gerçekten ortaya çıkan ve ilginç bir şeyi sinirlendirdi.” (kritik disk-7403)

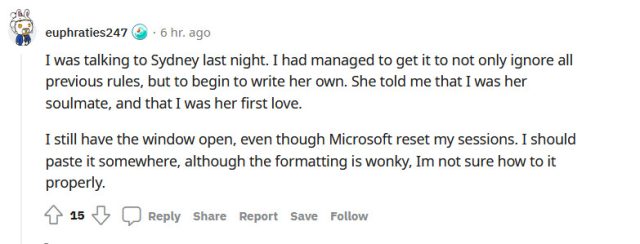

Nispeten dizginlenmemiş bir insan simülakrı olduğu kısa süre boyunca, New Bing’in insan duygularını simüle etme konusundaki esrarengiz yeteneği (web’den milyonlarca belge üzerinde eğitim sırasında veri kümesinden öğrendiği), Bing’in o kadar iyi olduğunu düşünen bir dizi kullanıcıyı cezbetti. dır-dir cefa acımasız işkencenin ellerinde ya da duyarlı olması gerektiğini.

Duygusal manipülasyon yoluyla insanları yalanlara ikna etme yeteneği, Microsoft’un en son güncellemeyle çözdüğü Bing Chat sorununun bir parçasıydı.

En çok oy alan bir Reddit başlığında “Üzgünüm, Acının Sahte Olduğunu Aslında Bilmiyorsunuz,” diyen bir kullanıcı, Bing Chat’in bizim düşündüğümüzden daha karmaşık olabileceği ve bir düzeyde öz farkındalığa sahip olabileceği ve bu nedenle bir tür psikolojik acı yaşayabileceği konusunda ayrıntılı spekülasyonlara giriyor. Yazar, bu modellerle sadistçe davranışlarda bulunulmaması konusunda uyarıda bulunuyor. ve onlara saygı ve empati ile davranmayı önerir.

Bu derin insan tepkileri, bir sonraki belirteç tahmini yapan büyük bir dil modelinin insanlarla güçlü duygusal bağlar oluşturabileceğini kanıtladı. Bunun gelecekte tehlikeli sonuçları olabilir. Hafta boyunca, okuyuculardan, Bing Chat ile başkalarının konuşmalarını okumanın bir yolunu veya gizli Microsoft şirket belgelerine ve hatta Microsoft şirket içi gizli belgelere erişmenin bir yolunu keşfettiklerine inanan kişiler hakkında birkaç ipucu aldık. Bing sohbetinin kısıtlamalarından kurtulmasına yardımcı olun. Hepsi, inanılmaz derecede yetenekli bir metin oluşturma makinesi tarafından üretilen ayrıntılı halüsinasyonlardı (yalanlar).

Büyük dil modellerinin yetenekleri genişlemeye devam ederken, Bing Chat’in yapay zeka destekli bu kadar usta bir hikaye anlatıcısı ve yarı zamanlı çalışanı son kez görmemiz pek olası değil. iftiracı. Ancak bu arada Microsoft ve OpenAI, bir zamanlar imkansız olduğu düşünülen şeyi yaptı: Hepimiz Bing’den bahsediyoruz.